284

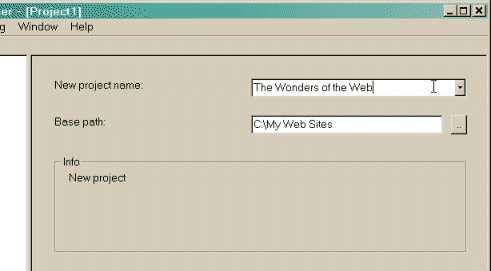

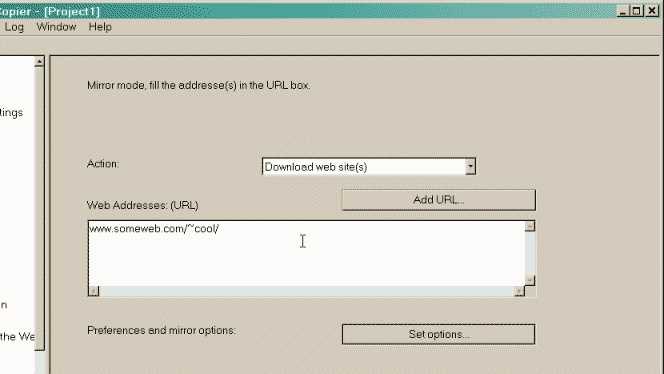

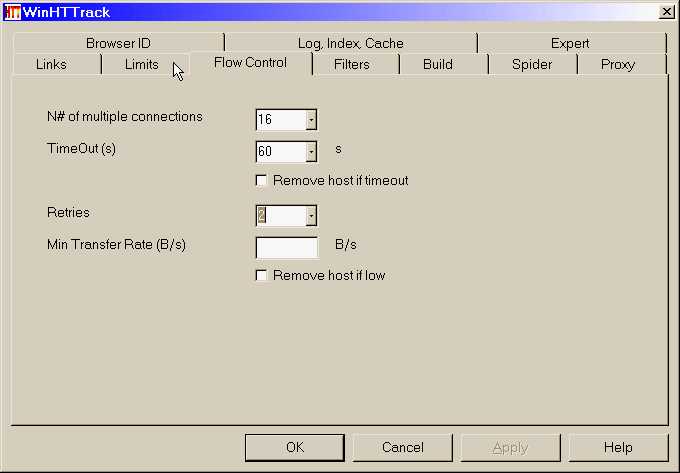

HTTrack ist ein kostenloses (GPL, libre / free Software) und benutzerfreundliches Offline-Browser-Dienstprogramm.Sie können eine World Wide Web-Site aus dem Internet in ein lokales Verzeichnis herunterladen, alle Verzeichnisse rekursiv erstellen und HTML, Bilder und andere Dateien vom Server auf Ihren Computer übertragen.HTTrack ordnet die relative Linkstruktur der ursprünglichen Sites an.Öffnen Sie einfach eine Seite der gespiegelten Website in Ihrem Browser, und Sie können die Website von Link zu Link durchsuchen, als würden Sie sie online anzeigen.HTTrack kann auch eine vorhandene gespiegelte Site aktualisieren und unterbrochene Downloads fortsetzen.HTTrack ist vollständig konfigurierbar und verfügt über ein integriertes Hilfesystem.WinHTTrack ist die Windows 9x / NT / 2000 / XP / Vista-Version von HTTrack und WebHTTrack die Linux / Unix / BSD-Version.

Webseite:

https://www.httrack.comEigenschaften

Kategorien

Alternativen zu HTTrack für alle Plattformen mit einer Lizenz

358

85

44

34

27

Offline Explorer

MetaProducts Offline Explorer ist ein Windows XP / 2003/2008 / Vista / 7/8/10-Programm, mit dem Sie eine unbegrenzte Anzahl Ihrer bevorzugten Web- und FTP-Sites herunterladen können, um später offline zu sein.

- Bezahlte

- Windows

17

SiteSucker

macOS-Anwendung, die automatisch Websites aus dem Internet herunterlädt.Dies geschieht durch asynchrones Kopieren der Webseiten, Bilder, PDFs, Stylesheets und anderer Dateien der Site auf Ihre lokale Festplatte, wobei die Verzeichnisstruktur der Site dupliziert wird.

16

Teleport Pro

Teleport Pro ist ein universelles Tool zum Abrufen von Daten aus dem Internet.

- Bezahlte

- Windows

14

PageArchiver

PageArchiver (früher als "Scrapbook for SingleFile" bezeichnet) ist eine Chrome-Erweiterung, mit der Sie Webseiten zum Offline-Lesen archivieren können.

14

12

ArchiveBox

🗃 Das selbst gehostete Open Source-Webarchiv.Nimmt Browserverlauf / Lesezeichen / Pocket / Pinnwand / etc. Auf, speichert HTML, JS, PDFs, Medien und mehr.

- Kostenlose

12

11

HTTP Ripper

HTTP Ripper ist ein Tool zum Auslesen von Inhalten aus dem Web.Beispiele * Laden Sie Filme von Video-Sites herunter * Laden Sie Musik von der Website Ihrer Lieblingsbands herunter

7

WebScrapBook

Eine Browsererweiterung, die die Webseite mit hochgradig anpassbaren Konfigurationen originalgetreu erfasst.

7

7

Ultra Web Archive

Damit Sie die gesamte Website archivieren können, müssen Sie die gesamte Seitenhierarchie für das Offline-Browsen auf einer lokalen Festplatte speichern.

- Freemium

- Web

- Software as a Service (SaaS)